※使用しているNUKEのバージョン:NUKEX 10.0v4

使用しているCARA VRのバージョン:CARA VR 1.0v3

こちらの記事では、NUKE と CARA VR を使用して、実写のVR素材と、3Dのオブジェクトの合成を行う方法を2回に分けて紹介致します。

※フッテージ提供:VoltFX社(Credits: Footage provided by VoltFX.)

▼CARA VRの概要

CARA VRは、NUKEと同じThe Foundry社製品の一つで、NUKE専用のVRプラグインツールセットです。360度のシーケンスのステッチングや自動色調補正、360度シーケンスに対応したトラッカー等のノードが含まれており、通常のNUKEのノードと組み合わせて使用することができます。

▼目標

NUKE内でCARA VRの機能を使用し、実写のシーケンスと、3Dオブジェクトの合成を行うことです。

▼今回の内容

今回は、実写のフッテージを合成するための設定と、3Dオブジェクトを合成するためのカメラの出力までを簡単に紹介致します。

▼カメラリグの解析

まず、複数のカメラで撮影したフッテージをReadノードで読み込みます。

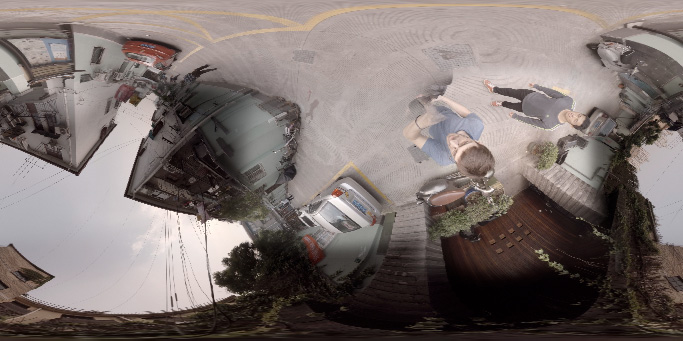

ContactSheetノードで一列に並べた画像がこちらです。

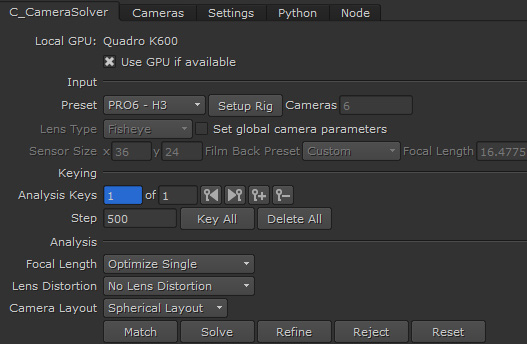

これらの撮影されたフッテージからカメラリグの位置関係の解析を行います。フッテージをすべて選択した状態でC_CameraSolverノードを作成します。

撮影したカメラの設定が確認できている場合は、以下の画像の[Input]の項目で設定を行います。該当するプリセットがある場合は[Preset]から選択します。[Match]で特徴点を検知し、[Solve]で解析し、解析結果によって各画像が展開されます。

この時点では天地の認識がないため、水平線の設定をします。設定は、C_CameraSolverノードの中で行えます。

▼360度フッテージの調整

続けて、C_ColourMatcherノードを接続します。[Analyse]ボタンを押すだけで、以下の画像のように、カメラ間の露出の違いを自動で補正することができます。

さらに、C_Stitcherノードをつなぎ、各カメラ間のステッチングを行います。こちらも、ある程度自動で行われます。必要に応じて、各カメラ(ビュー)の情報を抜き出して、通常のNUKEのノード(RotoやSplineWarpノード)を組み合わせて、ある一部分に対して修正することができます。

また、以下の画像の赤枠部分のみをC_SphericalTransformノードを使用することでLat-LongスペースからRectLinearスペースに変換します。これにより、通常のNUKE(NUKEX)ノードが使用できます。

カメラプロジェクションを行い、消し込みを行った後、再度C_SphericalTransformノードでLat-Longスペースに変換して、元のフッテージと合成することで、360度フッテージのクリーンプレートを作成します。

▼カメラの出力

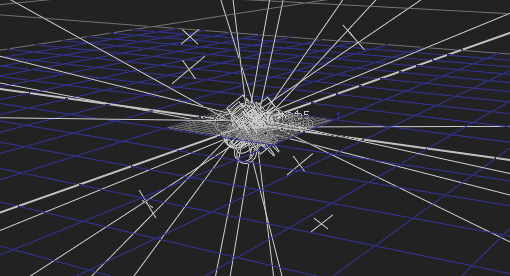

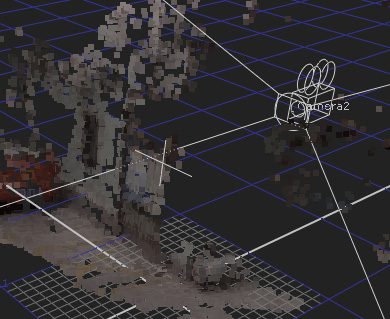

カメラリグは、最初のC_CameraSolverノードから出力することができます。[Export]の[Cameras]から以下のようなリグを出力することができます。

▼動くカメラリグ用のカメラトラッキング

カメラリグが動く場合、重要なのはそのカメラの動きのみです。どの位置にカメラがあるかは、あまり重要ではありません。基本的には、C_SphericalTransformノードを使用し、NUKEXのCameraTrackerノードで単一のカメラのアニメーションを取得します。

そして、3DCGソフトウェア側のレンダリングはSphericalモードで行います。

次回は、最後に取得したカメラを利用した3DCG側の内容と、NUKEへのインポート、合成について紹介する予定です。